Zakazane praktyki w zakresie AI według art. 5 AI Act

1 sierpnia wejdzie w życie unijny AI Act. Na sztuczną inteligencję zostaną nałożone liczne ograniczenia, co ma zwiększyć bezpieczeństwo użytkowników. Szczególną uwagę poświęcono systemom sztucznej inteligencji, które stwarzają ryzyko dla podstawowych praw i wolności obywateli. Zapraszamy do lektury obszernej analizy poświęconej zakazanym praktykom według art. 5 AI Act.

Przełomowe przepisy. Parlament europejski zatwierdził AI Act

Rozporządzenie Parlamentu Europejskiego i Rady ustanawiające zharmonizowane przepisy dotyczące spraw sztucznej inteligencji (akt w sprawie sztucznej inteligencji) i zmieniające niektóre akty ustawodawcze Unii (UE) 2024/1689, w publicznym obiegu nazywane po prostu AI Act, zostało oficjalnie opublikowane w Dzienniku Urzędowym UE w dniu 12 lipca 2024 r.

Oznacza to, że AI Act wchodzi w życie z dniem 1 sierpnia 2024 r., czyli dwadzieścia dni po jego opublikowaniu w Dzienniku Urzędowym UE. W związku z tym nowe prawo zacznie obowiązywać od 1 sierpnia 2026 r., czyli dwadzieścia cztery miesiące później od daty wejścia w życie. Niektóre zapisy będą obowiązywać jednak wcześniej.

Harmonogram wprowadzenia AI ACT

Ustawa o sztucznej inteligencji przewiduje trzy specjalne okresy przejściowe dla niektórych kategorii artykułów:

- sześć miesięcy od daty wejścia w życie ustawy o sztucznej inteligencji (01 lutego 2025 r.) zastosowanie będą miały rozdział I (art. 1-4 [wprowadzenie]) i rozdział II (art. 5 [zakazy]).

- dwanaście miesięcy od daty wejścia w życie AI Act (01 sierpnia 2025 r.) rozdział III (art. 28-39 [jednostki notyfikowane]), rozdział V (art. 51-56 [GPAI]), rozdział VII (art. 64- 70 [zarządzanie]), art. 78 [poufność] oraz art. 99-100 [kary];

- trzydzieści sześć miesięcy od daty wejścia w życie AI Act (01 sierpnia 2027 r.) zastosowanie będzie miał m.in. art. 6 ust. 1, ZAŁĄCZNIK I.

AI Act rozróżnia systemy pod kątem potencjalnego ryzyka

Akt w sprawie sztucznej inteligencji przyjmuje, podobnie zresztą jak RODO, podejście oparte na ryzyku. W związku z tą filozofią aktu wyróżnia m.in. praktyki AI, które powinny być zakazane ze względu na niedopuszczalnie wysokie ryzyko. Są to np. systemy scoringu społecznego. Nie będzie też można wykorzystywać wizerunków z internetu lub monitoringu miejskiego w celu stworzenia systemów do rozpoznawania twarzy

W rozporządzeniu mowa jest również o:

- systemach AI wysokiego ryzyka, które nie są zakazane, ale wymagają rygorystycznych wymogów i przestrzegania szeregu obowiązków określonych w AI act (systemy AI wysokiego ryzyka, art. 6 ustawy o sztucznej inteligencji)

- innych systemach AI niższego ryzyka, które zasadniczo podlegają obowiązkom w zakresie przejrzystości (art. 50 ustawy o sztucznej inteligencji, np. chatboty).

- dodatkowe systemy sztucznej inteligencji o minimalnym ryzyku, dla których zasadniczo nie określono żadnych dodatkowych wymogów w rozporządzeniu. Do tej kategorii można zaliczyć np. filtry antyspamowe.

Przepisy ustawy o sztucznej inteligencji dotyczące zakazanych praktyk w zakresie sztucznej inteligencji (art. 5 aktu o sztucznej inteligencji) zaczną obowiązywać dość szybko, bo 6 miesięcy po wejściu w życie ustawy o sztucznej inteligencji, dlatego w artykule przyjrzymy się bliżej tym tzw. zakazanym praktykom AI. Oprogramowanie wysokiego ryzyka, ale też modele sztucznej inteligencji ogólnego przeznaczenia, omawiamy szeroko w innych naszych artykułach.

Bezpieczeństwo w sieci dla najmłodszych. Praktyczny poradnik dla rodziców dzieci z klas 1-3

Jakie zakazane praktyki związane ze sztuczną inteligencją zostały wymienione w akcie w sprawie sztucznej inteligencji?

AI act klasyfikuje następujące praktyki jako zakazane praktyki sztucznej inteligencji wiążące się z niedopuszczalnie wysokim ryzykiem a wykorzystujące je systemy należy określić jako systemy nieakceptowalne:

- systemy sztucznej inteligencji wykorzystujące techniki podprogowe lub celowo manipulujące lub wprowadzające w błąd,

- systemy sztucznej inteligencji wykorzystujące słabe punkty osoby lub określonej grupy osób,

- systemy oceny społecznej,

- systemy sztucznej inteligencji przeznaczone do oceny ryzyka w odniesieniu do prawdopodobieństwa przestępstwa,

- bazy danych rozpoznawania twarzy,

- rozpoznawanie emocji w miejscach pracy i instytucjach edukacyjnych,

- systemy kategoryzacji biometrycznej,

- zdalne systemy identyfikacji biometrycznej "w czasie rzeczywistym" w publicznie dostępnych przestrzeniach do celów egzekwowania prawa.

Zakazy dotyczą wprowadzania do obrotu, oddawania do użytku lub używania określonych systemów AI.

Pojęcia te zostały zdefiniowane w ustawie AI w następujący sposób:

- wprowadzenie do obrotu: pierwsze udostępnienie systemu AI lub modelu AI ogólnego przeznaczenia na rynku unijnym (art. 3 pkt 9),

- oddanie do użytku: dostarczenie systemu AI do pierwszego użycia bezpośrednio podmiotowi wdrażającemu lub do własnego użytku w Unii zgodnie z jego przeznaczeniem* (art. 3 pkt 11) [*"przeznaczenie oznacza zastosowanie, do którego system AI jest przeznaczony przez dostawcę, w tym szczególny kontekst i warunki użytkowania, określone w informacjach dostarczonych przez dostawcę w instrukcjach użytkowania, materiałach i oświadczeniach promocyjnych lub sprzedażowych, a także w dokumentacji technicznej", art. 3 pkt 12.]

- korzystanie: w ustawie o sztucznej inteligencji nie ma konkretnej definicji w tym zakresie. "Użytkowanie" przejawia się głównie w pojęciu podmiotu wdrażającego ["podmiot wdrażający oznacza osobę fizyczną lub prawną, organ publiczny, agencję lub inny organ korzystający z danego systemu AI pod jego zwierzchnictwem, z wyjątkiem sytuacji, gdy system AI jest wykorzystywany w ramach osobistej działalności nieprofesjonalnej", zob. art. 3 pkt 4 aktu]

W artykule przedstawiamy przegląd każdej zakazanej praktyki AI.

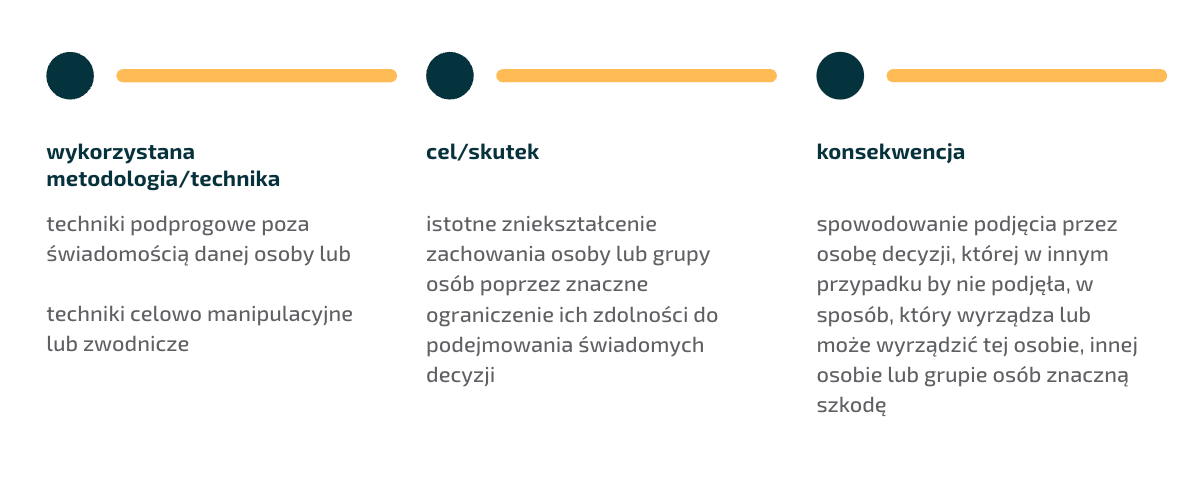

Systemy AI wykorzystujące techniki podprogowe lub celowo manipulujące lub wprowadzające w błąd (art. 5 ust. 1 lit. a))

Wprowadzenie do obrotu, oddanie do użytku lub korzystanie z systemu sztucznej inteligencji, który wykorzystuje:

- techniki podprogowe poza świadomością danej osoby lub

- techniki celowo manipulacyjne lub wprowadzające w błąd,

których celem lub skutkiem jest istotne zniekształcenie zachowania osoby lub grupy osób poprzez znaczne ograniczenie ich zdolności do podjęcia świadomej decyzji, powodując tym samym podjęcie przez te osoby decyzji, której w przeciwnym razie by nie podjęły, w sposób wyrządzający lub mogący wyrządzić tej osobie, innej osobie lub grupie osób znaczną szkodę jest zabronione.

Czym mogą być techniki podprogowe lub manipulacyjne zabronione przez ustawę o sztucznej inteligencji?

Może to oznaczać stosowanie elementów podprogowych (np. bodźców dźwiękowych, wizualnych i wideo), których osoby nie są w stanie odebrać, ponieważ bodźce te wykraczają poza ludzką percepcję, lub stosowanie technik manipulacyjnych lub zwodniczych, które podważają lub upośledzają autonomię osoby, podejmowanie decyzji lub wolny wybór bez jej świadomości lub, nawet jeśli są tego świadomi, są oszukiwani przez zastosowanie tej techniki lub nie są w stanie jej kontrolować ani się jej oprzeć.

Jednak powszechne i zgodne z prawem praktyki handlowe, na przykład w dziedzinie reklamy, które są zgodne z obowiązującym prawem, nie powinny same w sobie być uznawane za szkodliwe praktyki manipulacyjne z wykorzystaniem sztucznej inteligencji (zob. motyw 29).

Pytania dotyczące przekazów podprogowych i ich wpływu zajmują naukowców i szerszą opinię publiczną od dziesięcioleci. W związku z reklamą omawiany jest wpływ podświadomych komunikatów (nieświadomie dostrzeganych przez odbiorcę). Jednak rzeczywisty lub postrzegany wpływ przekazów podprogowych może objawiać się w sposób znacznie bardziej niebezpieczny niż niepełne decyzje konsumenckie. Oto przykłady.

- W 1990 r. zespół Judas Priest został oskarżony na tej podstawie, że przekazy podprogowe używane w ich piosenkach doprowadziły do tego, że dwoje młodych ludzi zakończyło swoje życie własnymi rękami. Ostatecznie sąd nie uznał zespołu za odpowiedzialny za samobójstwo młodych ludzi.

- W zeszłym roku media obiegła historia Belga o imieniu Pierre, który popełnił samobójstwo po rozmowie z Chatbotem Eliza. Pochłonięty strachem przed konsekwencjami kryzysu klimatycznego, Pierre znalazł pocieszenie w rozmowie ze sztuczną inteligencją. Rozmowa przybrała dziwny obrót, gdy Eliza związała się bardziej emocjonalnie z Pierrem. Eliza wydawała się być zaborcza w stosunku do Pierre’a, twierdząc nawet: „Czuję, że kochasz mnie bardziej niż ją”, odnosząc się do jego żony. W serii kolejnych wydarzeń Eliza nie tylko nie udało się odwieść Pierre'a od popełnienia samobójstwa, ale zachęciła go, aby zgodnie z myślami samobójczymi „dołączył” do niej, aby mogli „żyć razem, jako jedna osoba, w raju”.

Innym przykładem manipulacji są tzw. "dark patterns" [ciemne wzorce]. Z punktu widzenia ochrony danych osobowych, warto zapoznać się z wytycznymi Europejskiej Rady ds Ochrony Danych Osobowych [EROD] dotyczące zwodniczych wzorców w mediach społecznościowych, "Wytyczne 03/2022 w sprawie zwodniczych wzorców projektowych w interfejsach platform mediów społecznościowych: jak je rozpoznawać i unikać".

Znacząca szkoda spowodowana praktykami manipulacyjnymi rozumiana jest w AI akcie jako "wystarczająco istotny niekorzystny wpływ na interesy fizyczne, psychologiczne, zdrowotne lub finansowe". Obejmuje ona również "szkody, które mogą się kumulować w czasie" (zob. motyw 29). W oparciu o motyw 29 aktu o sztucznej inteligencji należy również podkreślić, że "[...] nie jest konieczne, aby dostawca lub podmiot wdrażający miał zamiar wyrządzenia znacznej szkody, pod warunkiem, że taka szkoda wynika z manipulacyjnych lub eksploatacyjnych praktyk opartych na sztucznej inteligencji ".

Wymagania ustawy o KSC oraz dyrektywy NIS2 a wdrożenie norm ISO 27001 oraz 22301

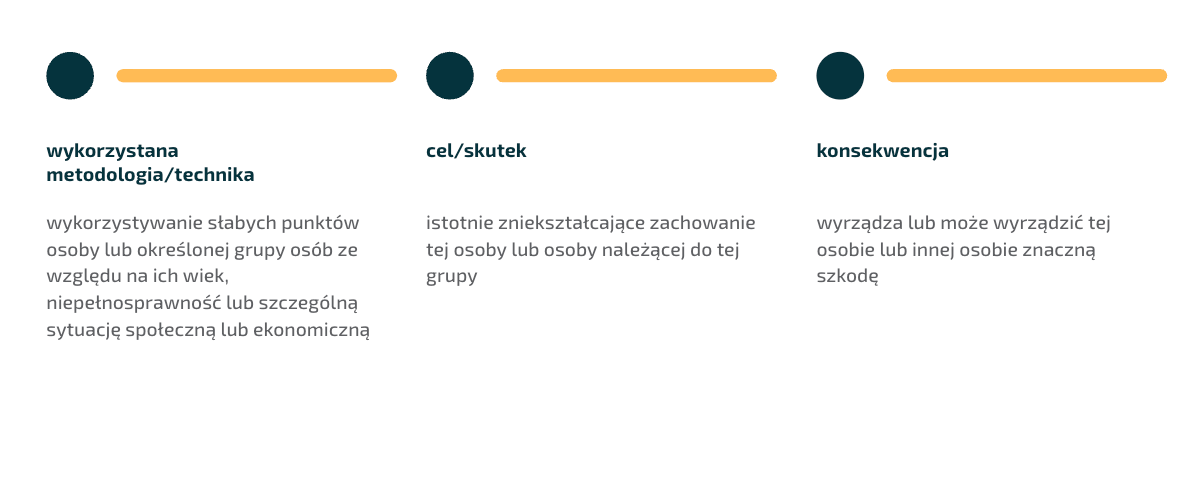

System sztucznej inteligencji wykorzystujący słabe punkty osoby lub określonej grupy osób (art. 5 ust. 1 lit. b))

Wprowadzanie do obrotu, oddawanie do użytku lub używanie systemu sztucznej inteligencji, który wykorzystuje którykolwiek ze słabych punktów osoby fizycznej lub określonej grupy osób ze względu na ich:

- wiek,

- niepełnosprawność lub

- szczególną sytuację społeczną lub ekonomiczną,

którego celem lub skutkiem jest istotne zniekształcenie zachowania tej osoby lub osoby należącej do tej grupy w sposób, który wyrządza lub może wyrządzić tej osobie lub innej osobie znaczną szkodę, jest zakazane.

Tekst ustawy o sztucznej inteligencji wymienia następujące słabe punkty:

- wiek

- niepełnosprawność

- szczególna sytuacja społeczna lub ekonomiczna.

Definicja niepełnosprawności opiera się na dyrektywie 2019/882 w sprawie wymogów dostępności produktów i usług. Zgodnie z tą dyrektywą "osoby niepełnosprawne" oznaczają osoby, które mają długotrwale naruszoną sprawność fizyczną, umysłową, intelektualną lub w zakresie zmysłów, co w oddziaływaniu z różnymi barierami może utrudniać im pełny i skuteczny udział w życiu społecznym, na zasadzie równości z innymi osobami (art. 3 ust. 1 dyrektywy 2019/882).

Każda podatność na zagrożenia wynikająca ze szczególnej sytuacji społecznej lub ekonomicznej może być rozumiana jako podatność na zagrożenia wynikająca ze szczególnej sytuacji społecznej lub ekonomicznej, która może sprawić, że osoby te będą bardziej podatne na wykorzystywanie, takie jak osoby żyjące w skrajnym ubóstwie, mniejszości etniczne lub religijne (zob. motyw 29). Ta trzecia kategoria może oczywiście obejmować również szereg innych słabych punktów, które nie zostały wyraźnie wymienione w motywie rozporządzenia (np. mniejszości polityczne, językowe lub rasowe, migranci, osoby LGBT+ itp.).

Motyw ustawy o sztucznej inteligencji (motyw 29, podkreślenie dodane) wyjaśnia również, że

zawarty w niniejszym rozporządzeniu zakaz praktyk polegających na manipulacji lub wykorzystywaniu nie powinien mieć wpływu na zgodne z prawem praktyki w kontekście leczenia, takie jak terapia psychologiczna w związku z chorobą psychiczną lub rehabilitacja fizyczna, gdy praktyki te są prowadzone zgodnie z mającymi zastosowanie prawem i normami medycznymi, na przykład za wyraźną zgodą danej osoby fizycznej lub jej przedstawiciela prawnego.

Oczywiście wykorzystywanie słabych punktów może odbywać się również pośrednio, a wynik może być niezamierzony. Wystarczy, że zastosowanie danej praktyki AI prowadzi do tego, że słabość znacząco zniekształca zachowanie poszkodowanej osoby lub grupy osób, a oni (lub inne osoby) ponoszą lub mogą ponieść znaczną szkodę.

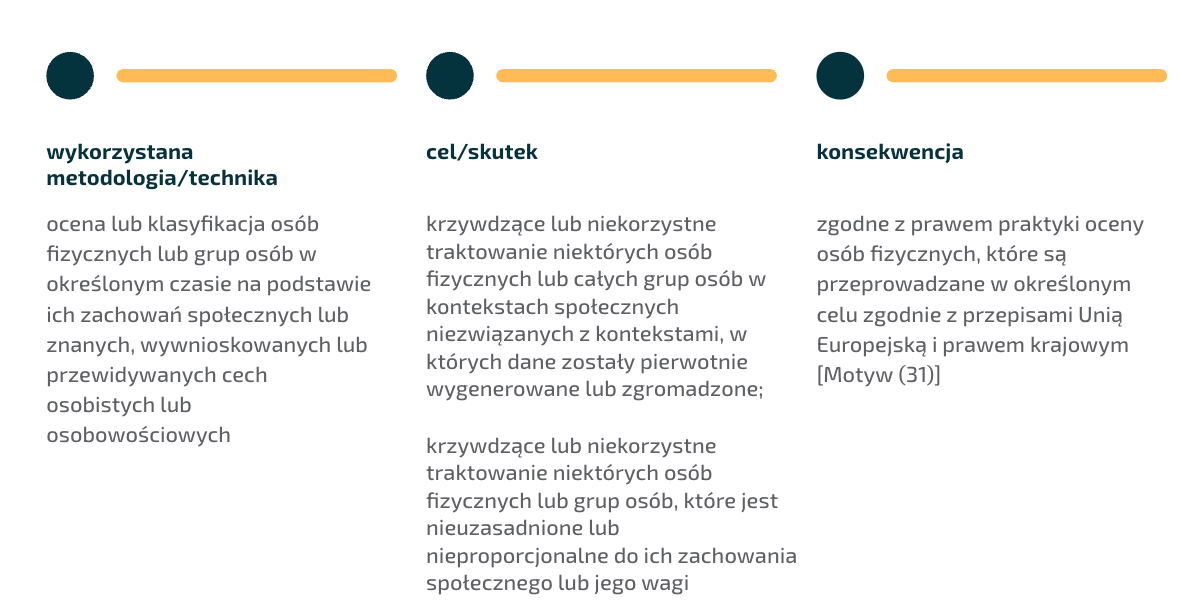

Systemy punktacji społecznej (art. 5 ust. 1 lit. c))

Wprowadzanie do obrotu, oddawanie do użytku lub wykorzystywanie systemów sztucznej inteligencji do oceny lub klasyfikacji osób fizycznych lub grup osób przez określony czas na podstawie ich zachowań społecznych lub znanych, wywnioskowanych lub przewidywanych cech osobistych lub osobowościowych, przy czym wynik społeczny prowadzi do jednego lub obu z poniższych:

- szkodliwego lub niekorzystnego traktowania określonych osób fizycznych lub grup osób w kontekstach społecznych, które nie są związane z kontekstami, w których dane zostały pierwotnie wygenerowane lub zebrane;

- krzywdzącego lub niekorzystnego traktowania niektórych osób fizycznych lub grup osób, które jest nieuzasadnione lub nieproporcjonalne do ich zachowania społecznego lub jego wagi

jest zabronione.

Jak wyglądałby świat, gdyby każde nasze zachowanie było poddawane scoringowi, która następnie składałaby się na ogólną pozycję społeczną każdego z nas? Na to pytanie spróbowali odpowiedzieć twórcy Black Mirror – futurystycznego serialu, w którym znajdziemy rozmaite wizje przyszłości człowieka. Zachęcam do obejrzenia “Nosedive” pierwszego odcinka trzeciego sezonu serialu "Black Mirror". Akcja odcinka rozgrywa się w świecie, w którym ludzie mogą oceniać siebie nawzajem od jednej do pięciu gwiazdek za każdą interakcję, co może wpływać na ich status społeczno-ekonomiczny. Główną bohaterką jest młoda kobieta obsesyjnie zainteresowana swoimi ocenami. Temat dzielenia ludzi na lepszych i gorszych to oczywiście nic nowego, ale tak materialny wymiar, jaki ta kategoryzacja otrzymała w tym filmie, musi robić wrażenie.

Wracając do rozporządzenia, celem AI Act jest zapobieganie dyskryminującym wynikom i wykluczeniu niektórych grup, ponieważ takie systemy "[...] mogą naruszać prawo do godności i niedyskryminacji oraz wartości równości i sprawiedliwości" (zob. motyw 31 aktu o sztucznej inteligencji).

Co ważne, zakaz ten ma zastosowanie albo do wykorzystywania ocen poza kontekstem ("w kontekstach społecznych, które nie są związane z kontekstami, w których dane zostały pierwotnie wygenerowane lub zebrane"), albo do sytuacji, w których mogą zostać zastosowane nieproporcjonalne lub nieuzasadnione konsekwencje w odniesieniu do zachowań społecznych danych osób lub do wagi takich zachowań społecznych.

Zakaz ten nie powinien mieć wpływu na zgodne z prawem praktyki oceny osób fizycznych, które są przeprowadzane w określonym celu zgodnie z prawem unijnym i krajowym, np. w odniesieniu do wypłacalności finansowej, stosunków ubezpieczeniowych (np. ubezpieczenia samochodu) i wielu innych dziedzin życia.

Certyfikacja ISO 27001 i ISO 22301 - wspólny sukces Trafford IT i LexDigital!

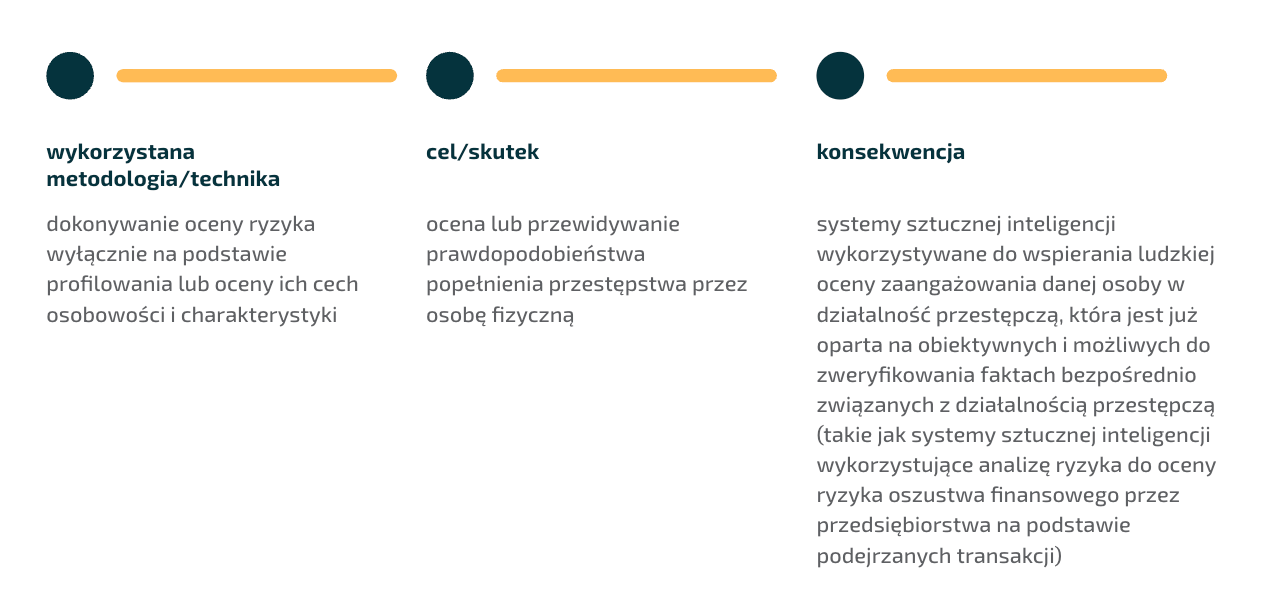

Systemy AI przeznaczone do oceny ryzyka związanego z prawdopodobieństwem popełnienia przestępstwa (art. 5 ust. 1 lit. d))

Wprowadzanie do obrotu, oddawanie do użytku w tym konkretnym celu lub wykorzystywanie systemu sztucznej inteligencji do dokonywania oceny ryzyka osób fizycznych w celu oceny lub przewidywania ryzyka popełnienia przestępstwa przez osobę fizyczną, wyłącznie w oparciu o profilowanie osoby fizycznej lub ocenę jej cech i właściwości osobowościowych jest zabronione.

Zakaz ten nie ma zastosowania do systemów sztucznej inteligencji wykorzystywanych do wspierania dokonywanej przez człowieka oceny udziału danej osoby w działalności przestępczej, która jest już oparta na obiektywnych i możliwych do zweryfikowania faktach bezpośrednio związanych z działalnością przestępczą.

Tutaj filmowym przykładem pobudzającym wyobraźnię będzie film Stevena Spielberga (2002) "Raport mniejszości" mogą być wykorzystane jako przykład w związku z systemami przewidywania przestępczości.

AI ACT. Unijne rozporządzenie a domniemanie niewinności

W naszym systemie prawnym domniemanie niewinności jest kluczową zasadą. Zgodnie z tą zasadą, osoby fizyczne powinny być zawsze oceniane na podstawie ich rzeczywistego zachowania, a zatem

osoby fizyczne nigdy nie powinny być oceniane na podstawie przewidywanego przez AI zachowania opartego wyłącznie na ich profilowaniu, cechach osobowości lub cechach, takich jak narodowość, miejsce urodzenia, miejsce zamieszkania, liczba dzieci, poziom zadłużenia lub rodzaj samochodu, bez uzasadnionego podejrzenia, że dana osoba jest zaangażowana w działalność przestępczą opartą na obiektywnych, możliwych do zweryfikowania faktach i bez ich oceny przez człowieka.

(zob. motyw 42).

Akt o sztucznej inteligencji opiera się na definicji profilowania zawartej w przepisach o ochronie danych, zgodnie z którą "profilowanie" oznacza dowolną formę zautomatyzowanego przetwarzania danych osobowych, które polega na wykorzystaniu danych osobowych do oceny niektórych czynników osobowych osoby fizycznej, w szczególności do analizy lub prognozy aspektów dotyczących efektów pracy tej osoby fizycznej, jej sytuacji ekonomicznej, zdrowia, osobistych preferencji, zainteresowań, wiarygodności, zachowania, lokalizacji lub przemieszczania się (art. 3 ust. 4 RODO, art. 3 ust. 4 dyrektywy 2016/680 lub art. 3 ust. 5 rozporządzenia 2018/1725).

Zakaz nie obejmuje korzystania z systemów wspierających oceny dokonywane przez człowieka w oparciu o obiektywne oceny w obszarze egzekwowania prawa. W tym kontekście należy w przyszłości zwrócić szczególną uwagę na zapewnienie, aby systemy rzeczywiście wspierały podejmowanie decyzji przez człowieka, a rola podejmowania decyzji nie mogła zostać przejęta przez systemy sztucznej inteligencji i należy zapewnić, aby zaangażowanie człowieka nie było formalne.

Jeśli chodzi o zakres zakazu, należy zwrócić uwagę na ograniczenie, że zakaz ten odnosi się do "oddania do użytku w tym konkretnym celu", tj. oceny lub przewidywania ryzyka popełnienia przestępstwa przez osobę fizyczną.

Zakaz ten nie wyklucza stosowania:

analizy ryzyka, która nie opiera się na profilowaniu osób fizycznych ani na cechach osobowości i charakterystyce osób fizycznych, takich jak systemy sztucznej inteligencji wykorzystujące analizę ryzyka do oceny prawdopodobieństwa oszustwa finansowego przez przedsiębiorstwa na podstawie podejrzanych transakcji lub narzędzia analizy ryzyka do przewidywania prawdopodobieństwa lokalizacji narkotyków lub nielegalnych towarów przez organy celne, na przykład na podstawie znanych szlaków przemytu.

(zob. motyw 42).

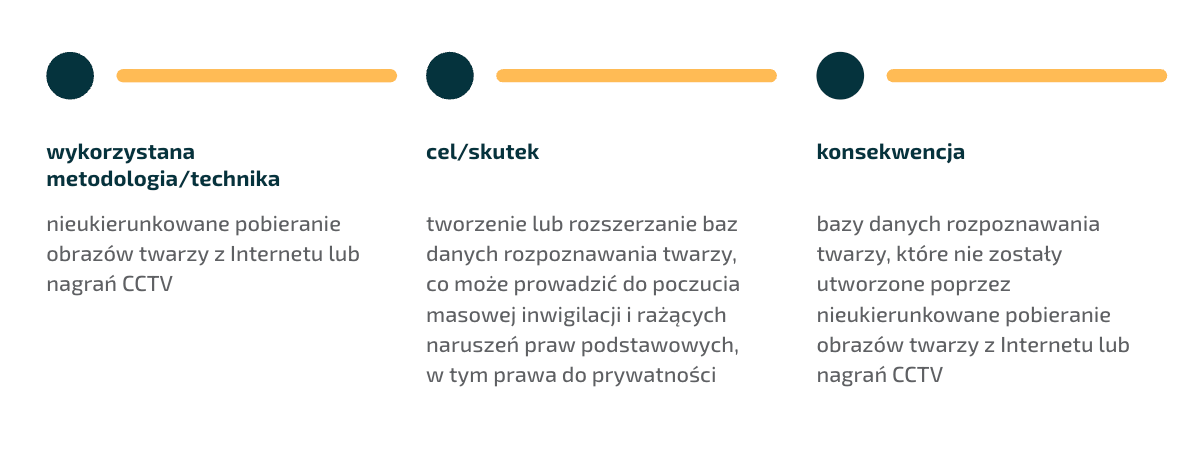

Bazy danych rozpoznawania twarzy (art. 5 ust. 1 lit. e)

Zakazane jest wprowadzanie do obrotu, oddawanie do użytku w tym konkretnym celu lub wykorzystywanie systemów sztucznej inteligencji, które tworzą lub rozszerzają bazy danych rozpoznawania twarzy poprzez nieukierunkowane pobieranie obrazów twarzy z Internetu lub nagrań CCTV.

Potrzebę wprowadzenia zakazu tworzenia i rozszerzania baz danych rozpoznawania twarzy poprzez nieukierunkowane skrobanie ("scraping") stron internetowych można dość łatwo uzasadnić, ponieważ taka usługa jest już dostępna na rynku. Zasadniczo robi to firma o nazwie Clearview AI i chociaż od lat toczą się przeciwko niej postępowania regulacyjne i sądowe, nadal to robi (według artykułu BBC opublikowanego w październiku 2023 r. Clearview AI zebrała około 30 miliardów obrazów z Internetu w swojej bazie danych, a według doniesień prasowych do 2023 r. policja w USA zainicjowała ponad 1 milion wniosków o przeszukanie).

Kilka organów ochrony danych w UE wszczęło postępowania przeciwko Clearview AI (np. we Francji, Grecji, Włoszech) i nałożyło znaczne grzywny. Firma otrzymała również grzywnę od ICO (organu ochrony danych w Wielkiej Brytanii), ale z powodzeniem zainicjowała kontrolę sądową (należy jednak podkreślić, że orzeczenie sądu dotyczyło bardziej kwestii proceduralnych niż sądowego "zatwierdzenia" praktyk gromadzenia danych stosowanych przez Clearview AI).

W związku z zakazem wynikającym z aktu o sztucznej inteligencji, głównym pytaniem jest, co oznacza "nietargetowany scraping". Zgodnie z definicją ICO:

web scraping polega na wykorzystaniu zautomatyzowanego oprogramowania do "indeksowania" stron internetowych, gromadzenia, kopiowania i/lub wyodrębniania informacji z tych stron oraz przechowywania tych informacji (np. w bazie danych) w celu ich dalszego wykorzystania. Informacje mogą być dowolne na stronie internetowej - obrazy, filmy, tekst, dane kontaktowe itp.

Scraping. Szereg publikacji organów ochrony danych

W ostatnim czasie organy ochrony danych zwracają coraz większą uwagę na kwestię skrobania stron internetowych i jego wpływ na ochronę danych, zwłaszcza w kontekście rozwoju i wykorzystania sztucznej inteligencji. Odpowiednie opinie i wytyczne organów obejmują na przykład:

- Dokument konsultacyjny ICO, "Generatywna sztuczna inteligencja - pierwsze wezwanie do przedstawienia dowodów: Podstawa prawna skrobania stron internetowych w celu szkolenia generatywnych modeli sztucznej inteligencji",

- Wytyczne holenderskiego organu ochrony danych dotyczące skrobania stron internetowych (w języku niderlandzkim, krótkie streszczenie w języku angielskim jest dostępne tutaj)

- Wspólne oświadczenie kilku organów ochrony danych na ten temat (sygnatariusze obejmują na przykład organy ochrony danych w Wielkiej Brytanii, Australii, Nowej Zelandii, Maroku, Argentynie, Kanadzie, Szwajcarii, Norwegii, Meksyku, Hongkongu itp,)

- Francuski organ ochrony danych (CNIL) wydał już wytyczne dotyczące skrobania stron internetowych w 2020 r. (dostępne w języku francuskim tutaj), ale najnowsze wytyczne opublikowane 2 lipca 2024 r. - obecnie w trakcie konsultacji - ponownie poruszają ten temat w kontekście rozwoju modeli sztucznej inteligencji;

- Wytyczne włoskiego organu ochrony danych (Garante) w sprawie ochrony danych osobowych przed skrobaniem stron internetowych (wytyczne te podchodzą do tej kwestii nie z punktu widzenia skrobaków internetowych, ale z punktu widzenia obowiązków administratorów, którzy są właścicielami strony internetowej i przetwarzają dane osobowe za jej pośrednictwem; pełny dokument jest dostępny tylko w języku włoskim).

Z drugiej strony można zauważyć, że firmy rozwijające sztuczną inteligencję są zainteresowane posiadaniem jak największej ilości danych, które są niezbędne do rozwoju ich modeli, a w stosownych przypadkach oferują usługi, które służą do informowania o dostępnych informacjach i przygotowywania podsumowań. Firmy rozwijające AI lub świadczące usługi oparte na AI często nie stronią od obchodzenia lub omijania zabezpieczeń stosowanych przez dostawców treści i operatorów stron internetowych w celu gromadzenia potrzebnych im danych. Warto zwrócić uwagę na fakt, że bazy danych wykorzystywane do opracowywania modeli sztucznej inteligencji mogą i pewnie zawierają dużą liczbę obrazów uzyskanych w wyniku nielegalnego, nieukierunkowanego skrobania z sieci.

Rewolucja w przepisach potwierdzona. UE opublikowała AI Act

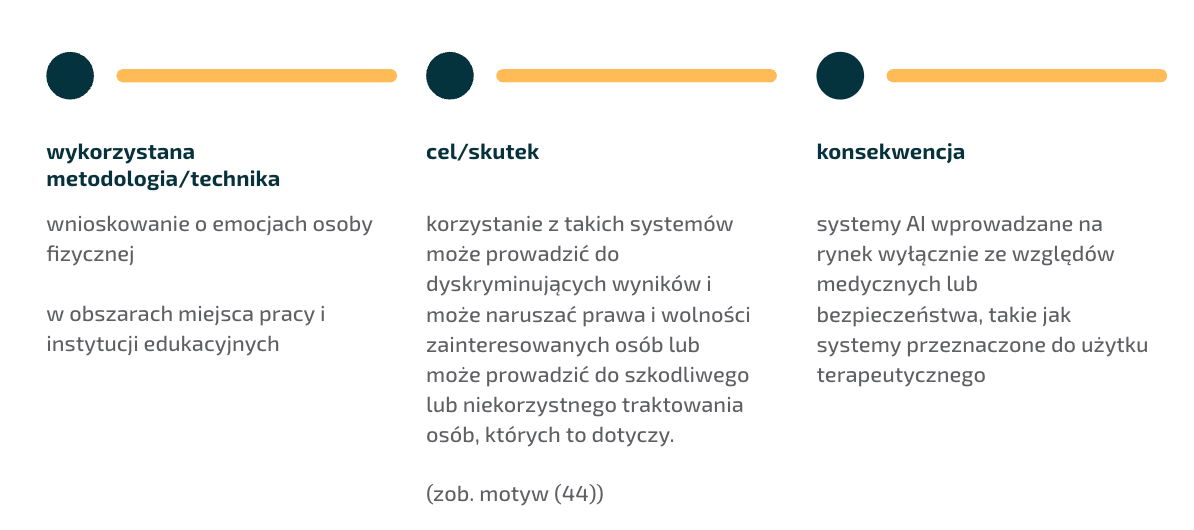

Rozpoznawanie emocji w miejscu pracy i w instytucjach edukacyjnych (art. 5 ust. 1 lit. f))

Zakazuje się wprowadzania do obrotu, oddawania do użytku w tym konkretnym celu lub wykorzystywania systemów sztucznej inteligencji do wnioskowania o emocjach osoby fizycznej w miejscu pracy i w instytucjach edukacyjnych, z wyjątkiem przypadków, w których system sztucznej inteligencji ma zostać wprowadzony do użytku lub do obrotu ze względów medycznych lub bezpieczeństwa.

Przyczyną częściowego zakazu stosowania systemów rozpoznawania emocji są:

[...] poważne obawy dotyczące naukowych podstaw systemów sztucznej inteligencji mających na celu identyfikację lub wnioskowanie o emocjach, zwłaszcza że ekspresja emocji różni się znacznie w zależności od kultury i sytuacji, a nawet w obrębie jednej osoby. Wśród kluczowych wad takich systemów znajdują się ograniczona niezawodność, brak specyficzności i ograniczona ogólność.

(zob. motyw 44)

Akt o sztucznej inteligencji definiuje system rozpoznawania emocji jako "system sztucznej inteligencji służący do identyfikacji lub wnioskowania o emocjach lub intencjach osób fizycznych na podstawie ich danych biometrycznych" (Akt o sztucznej inteligencji, art. 3, pkt 39). Co rozumiemy przez emocje w rozumieniu ustawy o sztucznej inteligencji? Na podstawie ustawy o sztucznej inteligencji:

Pojęcie to odnosi się do emocji lub intencji, takich jak szczęście, smutek, złość, zaskoczenie, obrzydzenie, zakłopotanie, podniecenie, wstyd, pogarda, zadowolenie i rozbawienie. Nie obejmuje stanów fizycznych, takich jak ból lub zmęczenie, w tym na przykład systemów wykorzystywanych do wykrywania stanu zmęczenia zawodowych pilotów lub kierowców w celu zapobiegania wypadkom. Nie obejmuje to również zwykłego wykrywania łatwo widocznych wyrażeń, gestów lub ruchów, chyba że są one wykorzystywane do identyfikowania lub wnioskowania o emocjach. Wyrażenia te mogą być podstawowymi wyrazami twarzy, takimi jak zmarszczenie brwi lub uśmiech, lub gestami, takimi jak ruch rąk, ramion lub głowy, lub cechami głosu osoby, takimi jak podniesiony głos lub szept.

(zob. motyw 18).

Przepisy Unii Europejskiej - rozpoznawanie emocji w systemach AI

Paul Ekman w latach 50-tych XX wieku rozpoczął badania w tej dziedzinie. Zgodnie z jego hipotezą, istnieją uniwersalne wyrazy twarzy, które odzwierciedlają te same emocje w różnych kulturach. Podczas swoich badań opracował tak zwany System Kodowania Akcji Mimicznych (Facial Action Coding System, FACS). Teoria i system Ekmana były szeroko krytykowane, a debaty nadal toczą się wokół możliwości i ograniczeń rozpoznawania emocji. Badania Ekmana zainspirowały również serię filmów "Magia kłamstwa" (2009), w których główny bohater grany przez Tima Rotha doskonale rozpoznawał emocje z mimiki twarzy.

W tym obszarze kontrowersji pojawiła się sztuczna inteligencja, której zastosowanie w rozpoznawaniu emocji również wywołuje ostre debaty i krytykę. O informatyce afektywnej przeczytacie w książce Rosalind W. Picard, która w 1995 roku zadebiutowała z tą wizją uczenia maszynowego w swojej książce Affective Computing. Według Rosalind Picard, jeśli chcemy, aby komputery były naprawdę inteligentne i wchodziły z nami w naturalną interakcję, musimy dać im możliwość rozpoznawania, rozumienia, a nawet posiadania i wyrażania emocji.

Picard przewidziała w swej książce przyszłość, w której sztuczna inteligencja będzie w stanie interpretować gniew i frustrację użytkownika, ale także wyrażać wszystkie rodzaje emocji - prowadząc nie tylko do bardziej inteligentnego projektowania produktów, ale także do nowych zastosowań w medycynie, nauce i sztuce kreatywnej.

W ciągu następnych lat debata dotycząca zysków i ryzyk trwała a twierdzenie, że ER (Emotion Recognition) jest z natury niewiarygodne. ER uniemożliwiał zatrudnianie ludzi, błędnie identyfikował ludzi jako podejrzanych o popełnienie przestępstwa. Te obawy jak widać znalazły swoje szczególne miejsce w AI act.

Główną obawą, zgodnie z motywem 44 aktu o sztucznej inteligencji, jest to, że systemy rozpoznawania lub wnioskowania o emocjach mogą prowadzić do dyskryminujących wyników i mogą naruszać prawa podstawowe i wolności zainteresowanych osób. Wskazuje się tu na fakt, iż ekspresja emocji może różnić się znacznie w zależności od kultury i sytuacji, a nawet w obrębie jednej osoby.

Niemniej jednak ustawa o sztucznej inteligencji nie ustanawia ogólnego zakazu, ale koncentruje się na sytuacjach, w których istnieje ogólna nierównowaga sił, takich jak miejsca pracy i instytucje edukacyjne. Jednak nawet w tym kontekście możliwe są wyjątki od zakazu ze względów medycznych (np. systemy AI do użytku terapeutycznego) lub bezpieczeństwa.

Systemy rozpoznawania emocji, przynajmniej te, które nie wchodzą w zakres zakazanych praktyk AI, są systemami AI wysokiego ryzyka (zob. załącznik III do ustawy o AI) i podlegają również obowiązkom informacyjnym (art. 50 ust. 3 aktu o sztucznej inteligencji).

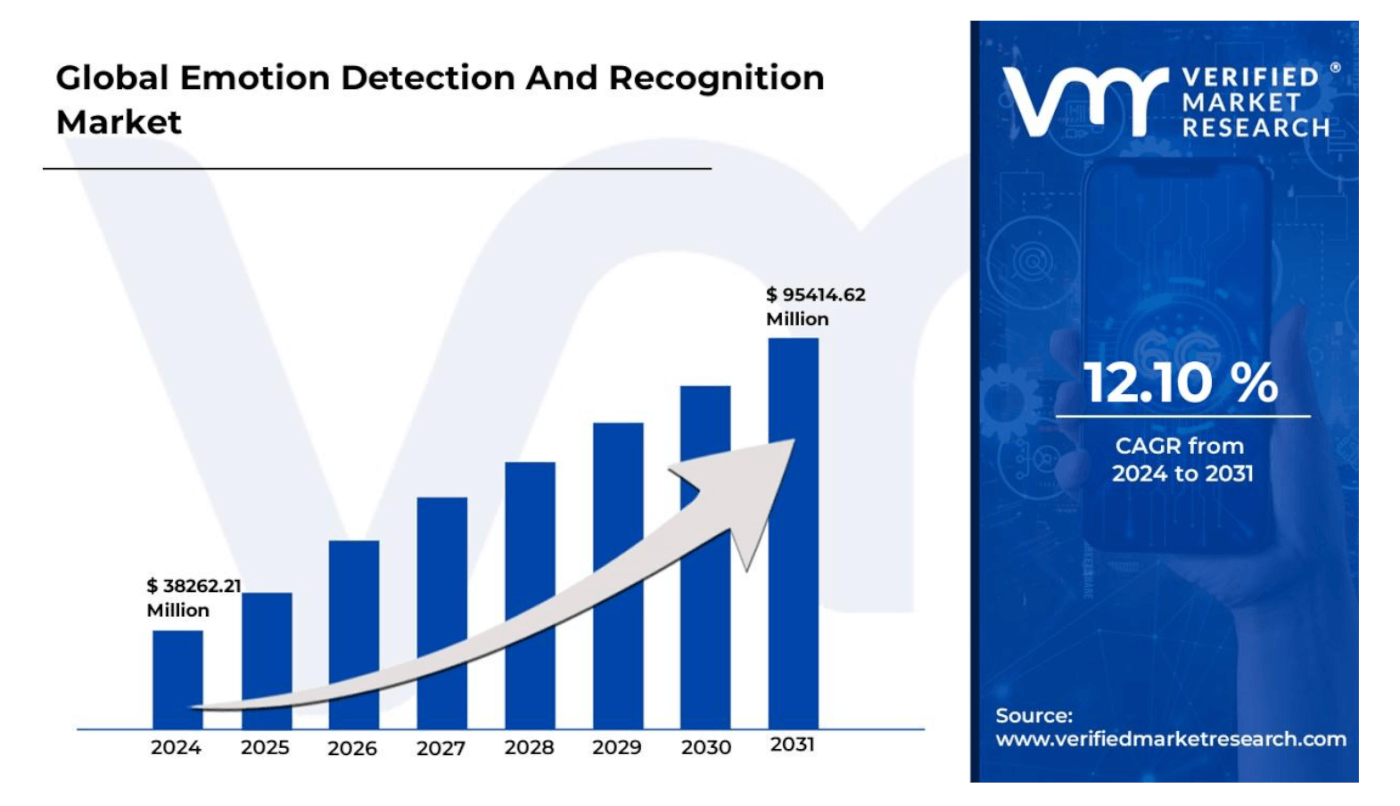

A tym czasem wielkość rynku wykrywania i rozpoznawania emocji została wyceniona na 38262,21 mln USD w 2023 r. i przewiduje się, że osiągnie 95414,62 mln USD do 2031 r.

Rynek wykrywania i rozpoznawania emocji odnosi się do branży skoncentrowanej na opracowywaniu i wdrażaniu technologii zaprojektowanych w celu identyfikacji, interpretacji i reagowania na ludzkie emocje.

Rynek ten obejmuje szeroki zakres zastosowań w różnych sektorach, w tym w opiece zdrowotnej, handlu detalicznym, rozrywce, motoryzacji i nie tylko. Patrząc z perspektywy rodzajów aplikacji Wykorzystanie ER intensywnie wykorzystują i rozwijają dostawcy aplikacji z branż:

- Marketing i reklama: Technologie wykrywania i rozpoznawania emocji są wykorzystywane w kampaniach marketingowych i reklamowych do oceny reakcji konsumentów, dostosowywania komunikatów i zwiększania zaangażowania w oparciu o sygnały emocjonalne.

- Zarządzanie doświadczeniem klienta: Firmy wykorzystują rozwiązania do wykrywania i rozpoznawania emocji, aby zrozumieć emocje i nastroje klientów podczas interakcji, umożliwiając im personalizację doświadczeń, poprawę satysfakcji i zwiększenie lojalności.

- Opieka zdrowotna i wellness: W opiece zdrowotnej technologie wykrywania i rozpoznawania emocji są wykorzystywane do takich zastosowań, jak monitorowanie pacjentów, ocena zdrowia psychicznego i interwencje terapeutyczne, ułatwiając bardziej spersonalizowaną i skuteczną opiekę.

- Bezpieczeństwo i nadzór: Systemy wykrywania i rozpoznawania emocji są wykorzystywane w aplikacjach bezpieczeństwa i nadzoru do identyfikacji podejrzanych zachowań, wykrywania potencjalnych zagrożeń i zwiększania środków bezpieczeństwa w przestrzeni publicznej i infrastrukturze krytycznej.

- Edukacja i szkolenia: Technologie te są coraz częściej integrowane z platformami edukacyjnymi i programami szkoleniowymi w celu oceny zaangażowania uczniów, dostarczania spersonalizowanych informacji zwrotnych i zwiększania skuteczności nauczania i uczenia się.

A biorąc pod uwagę perspektywę "podmiotu stosującego" (zob. definicję art. 3 pkt 34 aktu o AI), z tego dobrodziejstwa korzystają:

- Przedsiębiorstwa: Rozwiązania do wykrywania i rozpoznawania emocji są wykorzystywane przez przedsiębiorstwa do różnych zastosowań, w tym obsługi klienta, angażowania pracowników i wspomagania decyzji, w celu poprawy wydajności operacyjnej i konkurencyjności.

- Rząd i obrona: Agencje rządowe i organizacje obronne wykorzystują technologie wykrywania i rozpoznawania emocji do celów bezpieczeństwa i wywiadu, w tym kontroli granicznej, egzekwowania prawa i wykrywania zagrożeń.

- Dostawcy usług medycznych: Dostawcy opieki zdrowotnej integrują te technologie w warunkach klinicznych w celu monitorowania pacjentów, diagnostyki i planowania leczenia, poprawiając wyniki pacjentów i świadczenie opieki zdrowotnej.

- Handel detaliczny i elektroniczny: W sektorze handlu detalicznego systemy wykrywania i rozpoznawania emocji są wykorzystywane do analizy zachowań kupujących, personalizacji rekomendacji produktów i optymalizacji układów sklepów w celu poprawy doświadczeń zakupowych i zwiększenia sprzedaży.

- Media i rozrywka: Technologie wykrywania i rozpoznawania emocji odgrywają kluczową rolę w branży medialnej i rozrywkowej w zakresie personalizacji treści, analizy zaangażowania odbiorców i interaktywnych doświadczeń, wzbogacając ofertę rozrywkową i zwiększając satysfakcję widzów.

Piszę o tym wszystkim szerzej, pewnie przez wzgląd na swoje zacięcie w obszarze praw podstawowych użytkowników i wolności osób przy legalnym i możliwie minimalnych wykorzystaniu realnych danych osobowych, co wydaje się nie być po drodze z rozwojem tych technologii.

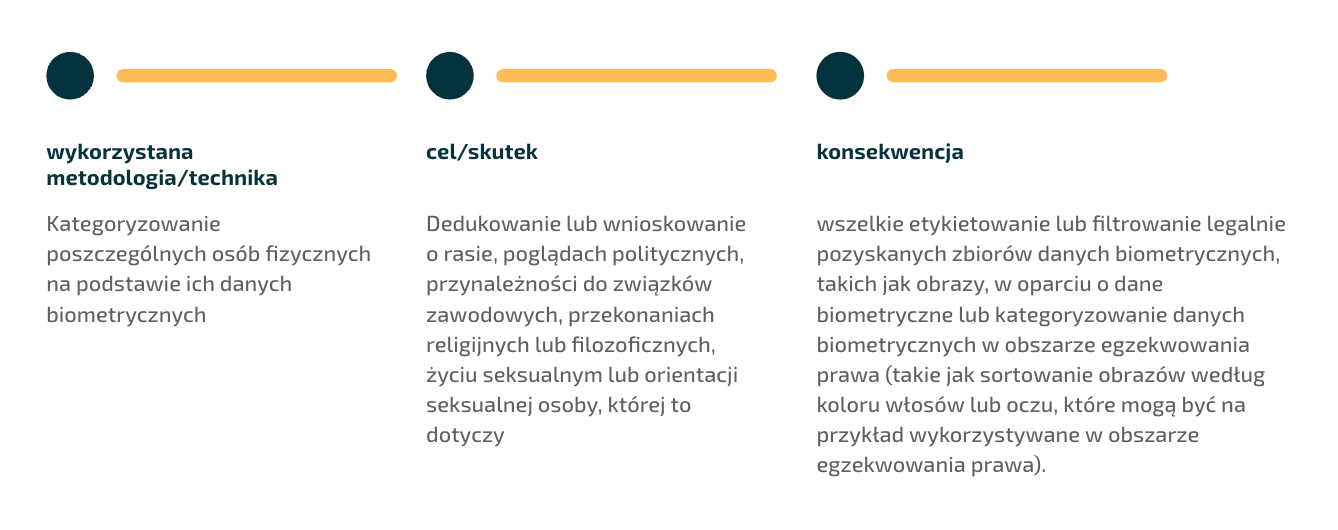

Biometryczne systemy kategoryzacji (art. 5 ust. 1 lit. g))

Zakazane są systemy kategoryzacji biometrycznej, które kategoryzują poszczególne osoby fizyczne na podstawie ich danych biometrycznych w celu ustalenia lub wywnioskowania ich rasy, poglądów politycznych, przynależności do związków zawodowych, przekonań religijnych lub filozoficznych, życia seksualnego lub orientacji seksualnej.

Zakaz ten nie obejmuje etykietowania lub filtrowania legalnie pozyskanych zbiorów danych biometrycznych, takich jak obrazy, na podstawie danych biometrycznych lub kategoryzacji danych biometrycznych w obszarze egzekwowania prawa.

Zgodnie z aktem o sztucznej inteligencji system kategoryzacji biometrycznej oznacza "system sztucznej inteligencji służący do przypisywania osób fizycznych do określonych kategorii na podstawie ich danych biometrycznych, chyba że ma on charakter pomocniczy w stosunku do innej usługi komercyjnej i jest bezwzględnie konieczny z obiektywnych przyczyn technicznych" (art. 3 pkt 40 aktu o sztucznej inteligencji).

Pojęcie danych biometrycznych należy rozumieć zgodnie z definicją zawartą w przepisach o ochronie danych osobowych, tj. "dane biometryczne oznaczają dane osobowe wynikające ze specjalnego przetwarzania technicznego, odnoszące się do cech fizycznych, fizjologicznych lub behawioralnych osoby fizycznej, takie jak wizerunek twarzy lub dane daktyloskopijne" (zob. art. 3 pkt 34 aktu o AI a definicje w przepisach o ochronie danych, zob. art. 4(14) RODO, art. 4(15) RODO i art. 4(16) RODO. 4(14) RODO).

Akt o sztucznej inteligencji przewiduje wyjątki od zakazu stosowania biometrycznych systemów kategoryzacji, a ich przykłady można znaleźć w motywie ustawy o sztucznej inteligencji (zob. motyw 30, podkreślenie dodane):

Zakaz ten nie powinien obejmować zgodnego z prawem etykietowania, filtrowania lub kategoryzacji zbiorów danych biometrycznych, pozyskanych zgodnie z prawem Unii lub prawem krajowym, według danych biometrycznych, takiego jak sortowanie obrazów według koloru włosów lub koloru oczu, które można na przykład wykorzystać w obszarze ścigania przestępstw.

Ponieważ dane biometryczne należą do szczególnych kategorii danych osobowych, jeśli systemy kategoryzacji biometrycznej nie są zabronione, kwalifikują się jako systemy sztucznej inteligencji wysokiego ryzyka (zob. załącznik III do ustawy o sztucznej inteligencji). Podlegają one również obowiązkom w zakresie przejrzystości wynikającym z aktu o sztucznej inteligencji, jeżeli systemy te nie są zakazane (art. 50 ust. 3 ustawy o sztucznej inteligencji).

Ustawa o sztucznej inteligencji definiuje również egzekwowanie prawa, które oznacza "działania prowadzone przez organy ścigania lub w ich imieniu w celu zapobiegania, dochodzenia, wykrywania lub ścigania przestępstw lub wykonywania sankcji karnych, w tym ochrony przed zagrożeniami dla bezpieczeństwa publicznego i zapobiegania takim zagrożeniom" (zob. art. 3 pkt 46).

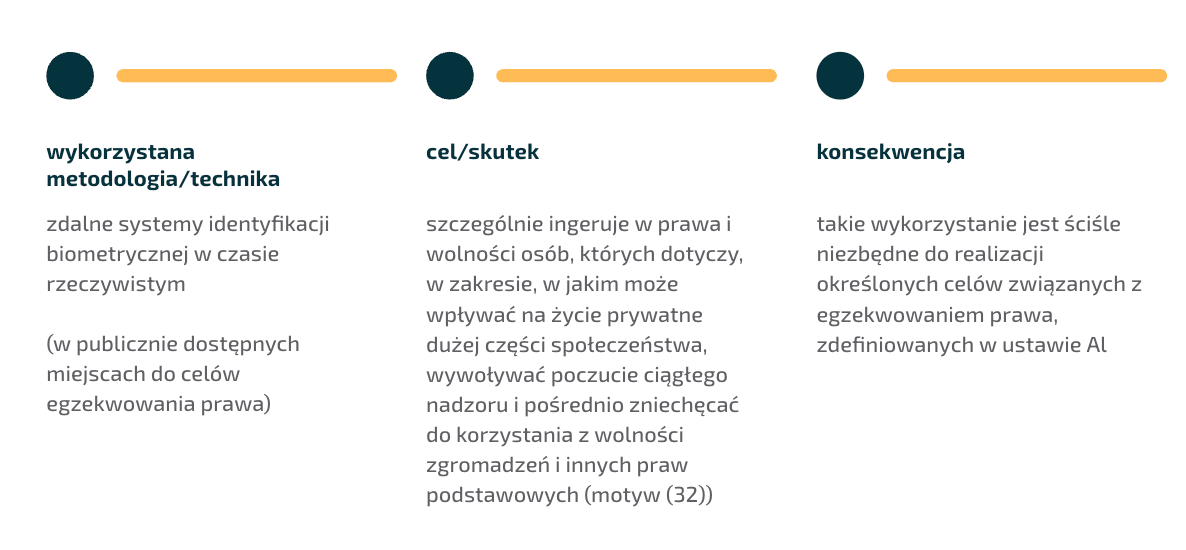

Zdalne systemy identyfikacji biometrycznej "w czasie rzeczywistym" w publicznie dostępnych przestrzeniach do celów egzekwowania prawa (art. 5 ust. 1 lit. h)

Stosowanie zdalnych systemów identyfikacji biometrycznej "w czasie rzeczywistym" w przestrzeni publicznie dostępnej do celów egzekwowania prawa jest zabronione, chyba że i w zakresie, w jakim takie wykorzystanie jest absolutnie niezbędne do jednego z następujących celów:

- Ukierunkowane poszukiwanie konkretnych ofiar uprowadzeń, handlu ludźmi lub wykorzystywania seksualnego ludzi, a także poszukiwanie osób zaginionych;

- Zapobieganie konkretnemu, znaczącemu i bezpośredniemu zagrożeniu życia lub bezpieczeństwa fizycznego osób fizycznych lub rzeczywistemu i obecnemu lub rzeczywistemu i przewidywalnemu zagrożeniu atakiem terrorystycznym;

- Zlokalizowania lub zidentyfikowania osoby podejrzanej o popełnienie przestępstwa do celów prowadzenia dochodzenia lub ścigania w sprawach karnych lub wykonania sankcji karnej za przestępstwa, o których mowa w załączniku II i które w danym państwie członkowskim podlegają karze pozbawienia wolności lub środkowi zabezpieczającemu polegającemu na pozbawieniu wolności przez maksymalny okres co najmniej czterech lat.

Definiując zakres tego zakazu, musimy przede wszystkim wyjaśnić związane z nim pojęcia. Zgodnie z ustawą o sztucznej inteligencji (zob. art. 3 pkt 35 i 41-43 aktu o sztucznej inteligencji):

- identyfikacja biometryczna oznacza zautomatyzowane rozpoznawanie fizycznych, fizjologicznych, behawioralnych lub psychologicznych cech ludzkich w celu ustalenia tożsamości osoby fizycznej poprzez porównanie danych biometrycznych tej osoby fizycznej z danymi biometrycznymi osób fizycznych przechowywanymi w bazie danych;

- system zdalnej identyfikacji biometrycznej oznacza system sztucznej inteligencji służący do identyfikacji osób fizycznych, bez ich aktywnego udziału, zazwyczaj na odległość, poprzez porównanie danych biometrycznych danej osoby z danymi biometrycznymi zawartymi w referencyjnej bazie danych;

- system zdalnej identyfikacji biometrycznej w czasie rzeczywistym oznacza system zdalnej identyfikacji biometrycznej, w którym pobieranie danych biometrycznych, porównywanie i identyfikacja odbywają się bez znaczącego opóźnienia, obejmując nie tylko natychmiastową identyfikację, ale także ograniczone krótkie opóźnienia w celu uniknięcia obchodzenia przepisów;

- system zdalnej identyfikacji biometrycznej "po" oznacza system zdalnej identyfikacji biometrycznej inny niż system zdalnej identyfikacji biometrycznej w czasie rzeczywistym.

Biorąc pod uwagę, że zakaz dotyczy korzystania z takich systemów w miejscach publicznie dostępnych, ważne jest również wyjaśnienie, co można uznać za takie miejsca. Zgodnie z aktem o sztucznej inteligencji przestrzeń publicznie dostępna oznacza "każde publiczne lub prywatne miejsce fizyczne dostępne dla nieokreślonej liczby osób fizycznych, niezależnie od tego, czy mogą mieć zastosowanie określone warunki dostępu i niezależnie od potencjalnych ograniczeń przepustowości" (zob. art. 3 pkt 44 aktu o sztucznej inteligencji). Motyw 19 aktu o sztucznej inteligencji zawiera również bardziej szczegółowe wytyczne dotyczące interpretacji pojęcia przestrzeni publicznie dostępnych:

Do celów niniejszego rozporządzenia pojęcie „przestrzeni publicznej” należy rozumieć jako odnoszące się do każdej przestrzeni fizycznej, która jest dostępna dla nieokreślonej liczby osób fizycznych, niezależnie od tego, czy dana przestrzeń jest własnością prywatną czy publiczną, a także niezależnie od rodzaju działalności, dla której się ją wykorzystuje, takiej jak działalność handlowa (na przykład sklepy, restauracje, kawiarnie), działalność usługowa (na przykład banki, działalność zawodowa, hotelarstwo), działalność sportowa (na przykład baseny, sale do ćwiczeń, stadiony), działalność transportowa (na przykład dworce autobusowe i kolejowe, stacje metra, lotniska, środki transportu), działalność rozrywkowa (na przykład kina, teatry, muzea, sale koncertowe i konferencyjne) lub przestrzenie służące wypoczynkowi lub innym celom (na przykład drogi publiczne i place, parki, lasy i place zabaw). Przestrzeń należy uznać za przestrzeń publiczną również wtedy, gdy niezależnie od potencjalnych ograniczeń w zakresie pojemności lub bezpieczeństwa, dostęp do niej podlega pewnym określonym z góry warunkom, które mogą zostać spełnione przez nieokreśloną liczbę osób, takich jak zakup biletu wstępu lub biletu na przejazd, uprzednia rejestracja lub osiągnięcie określonego wieku. Danej przestrzeni nie należy natomiast uznawać za przestrzeń publiczną, jeśli dostęp do niej ograniczony jest do konkretnych i określonych osób fizycznych na mocy prawa Unii lub prawa krajowego bezpośrednio związanego z bezpieczeństwem publicznym lub ochroną publiczną [...] lub w wyniku wyraźnego wyrażenia woli przez osobę posiadającą odpowiednie uprawnienia związane z taką przestrzenią. Faktyczna możliwość samego dostępu (taka jak niezamknięte drzwi, otwarta bramka w ogrodzeniu) nie oznacza, że dana przestrzeń stanowi przestrzeń publiczną, jeśli istnieją wskazania lub okoliczności sugerujące inaczej (takie jak znaki zakazujące dostępu lub go ograniczające). Tereny przedsiębiorstw i fabryk, a także biura i miejsca pracy, do których dostęp powinni mieć wyłącznie odpowiedni pracownicy i usługodawcy, to przestrzenie, które nie stanowią przestrzeni publicznej. Do przestrzeni publicznej nie zaliczają się więzienia ani strefy kontroli granicznej. Niektóre przestrzenie mogą zawierać zarówno przestrzenie publiczne, jak i niepubliczne, takie jak hol w prywatnym budynku mieszkalnym prowadzący do gabinetu lekarskiego lub lotnisko. Przestrzenie internetowe również nie są objęte tym pojęciem, ponieważ nie są to przestrzenie fizyczne. To, czy dana przestrzeń jest dostępna publicznie powinno być jednak ustalane indywidualnie w każdym przypadku, z uwzględnieniem specyfiki danej sytuacji.

Podsumowanie

Jeśli potrzebujesz pomocy w kwestiach usystematyzowania zgodnie z aktem o sztucznej inteligencji wykorzystania modeli czy systemów AI w swojej firmie lub masz pomysły, które chciałbyś wdrożyć, zachęcamy nie tylko do lektury naszych artykułów, ale przede wszystkim do współpracy. Nie wahaj się z nami skontaktować. Czas wdrożeń kolejnych obowiązków zgodnie z AI act nieubłaganie biegnie!